Willkommen bei ANN2thrive! Werfen Sie einen Blick in die Zukunft mit Deep Learning, einer bahnbrechenden Kraft in Wirtschaft und Technologie.

Deep Learning ist eine fortgeschrittene Technologie der künstlichen Intelligenz. Sie nutzt komplexe neuronale Netze, die die Lernmechanismen des menschlichen Gehirns nachahmen, um große Datenmengen zu analysieren und zu interpretieren.

Entdecken Sie, wie diese KI-Revolution Ihre Welt verändern kann. Tauchen Sie mit uns ein!

Herzlichst,

Elena Kisel

Gründerin, ANN2thrive

Inhaltsverzeichnis

1. Was ist Deep Learning?

Vom Algorithmus zum Intellekt: Die Grundbausteine des Deep Learning

Formale Definition des Deep Learning

Deep Learning ist eine Unterklasse des maschinellen Lernens, die mehrschichtige künstliche neuronale Netze verwendet, um komplexe Abstraktionen zu modellieren und Muster in Daten zu erkennen. Diese Netze bestehen aus mehreren Verarbeitungsschichten, von denen jede in der Lage ist, bestimmte Merkmale der Daten zu lernen, wobei von einfachen zu komplexeren Merkmalen vorgegangen wird. Diese Fähigkeit, Merkmale hierarchisch zu extrahieren, macht Deep Learning besonders leistungsfähig für Erkennungs-, Klassifizierungs- und Vorhersageaufgaben, die auf großen und komplexen Datensätzen basieren.

Einführung in Deep Learning

Deep Learning, ein Teilbereich des maschinellen Lernens, basiert auf Ideen und Methoden, die die Funktionsweise des menschlichen Gehirns nachahmen. Dieser Zweig der künstlichen Intelligenz (KI) konzentriert sich auf die Verwendung künstlicher neuronaler Netze zur Analyse und Verarbeitung großer Datenmengen. Deep Learning versucht, die menschliche Fähigkeit, aus Erfahrungen zu lernen, nachzuahmen, damit Maschinen selbstständig komplexe Muster und Abhängigkeiten in Daten erkennen können.

Von den Anfängen der KI zum Deep Learning

Historisch gesehen begann die künstliche Intelligenz mit Aufgaben, die komplexe intellektuelle Leistungen von Menschen erforderten, aber von Computern durch die Anwendung klar definierter Algorithmen gelöst werden konnten. Die eigentliche Herausforderung bestand jedoch darin, Aufgaben zu lösen, die für den Menschen trivial, aber schwer zu formalisieren waren, wie z. B. Sprach- oder Gesichtserkennung. Die Lösung dieser Probleme erforderte die Entwicklung von Systemen, die aus Beispielen und Erfahrungen lernen können.

Hierarchie von Konzepten und Lernstufen

Deep Learning verwendet einen hierarchischen Ansatz, bei dem jedes Konzept durch Verknüpfungen mit einfacheren Konzepten definiert wird. Dadurch können Maschinen schrittweise lernen, komplexe Muster zu erkennen, indem sie mit den grundlegendsten Mustern beginnen. Bei der Bilderkennung beispielsweise können die ersten Schichten eines neuronalen Netzes Kanten und Konturen erkennen, während tiefere Schichten komplexere Strukturen wie Objekte und Szenen erkennen können.

Herausforderungen und Lösungen für Deep Learning

Die Entwicklung des Deep Learning ist mit einer Reihe von Herausforderungen verbunden, darunter die Schwierigkeit, Rohdaten (z. B. Bildpixel) zu interpretieren, und der Bedarf an erheblichen Rechenressourcen für das Training von Modellen. Aktuelle Technologien und Algorithmen, wie z.B. mehrschichtige neuronale Netze, bewältigen diese Herausforderungen, indem sie die Rohdaten (z.B. Bildpixel) effizient verarbeiten und erhebliche Rechenressourcen für das Training der Modelle benötigen. bewältigen diese Herausforderungen, indem sie die Daten effizient verarbeiten und nützliche Informationen daraus extrahieren.

Deep Learning im praktischen Einsatz

In der Praxis reichen die Anwendungen von Deep Learning von der automatischen Bilderkennung und Textanalyse bis hin zur Entscheidungsfindung in Wirtschaft und Medizin. Möglich wird dies durch die Fähigkeit von Deep Learning, große Datenmengen zu verarbeiten und zu analysieren und dabei Muster zu erkennen, die der menschlichen Wahrnehmung nicht zugänglich sind.

Deep Learning ist ein mächtiges Werkzeug im Arsenal der künstlichen Intelligenz, mit dem Probleme gelöst werden können, die bisher unüberwindbar schienen. Mit seiner Fähigkeit, selbstständig aus großen Datenmengen zu lernen, eröffnet Deep Learning neue Horizonte für die Entwicklung der Technologie und ihrer Anwendungen im Alltag.

2. Die Geschichte des Deep Learning in Kürze

Von den Anfängen bis zum Turing Award: Schlüsselmomente in der Evolution des Deep Learning

Frühe Entwicklungen

Deep Learning hat seine Wurzeln in den 1960er Jahren, als Alexey Ivakhnenko das GMDH-ANN, das erste Feedforward-Multilayer-Perceptron-System (MLP) vom Typ Deep Learning, entwickelte. Zur gleichen Zeit schuf Karl Steinbuch eines der ersten künstlichen neuronalen Netze, das ebenfalls mehrere Schichten von Lerneinheiten enthielt und zu einem wichtigen Vorläufer der heutigen tiefen neuronalen Netze wurde.

Entwicklungen auf dem Gebiet des maschinellen Sehens

1980 schlug Kunihiko Fukushima Neocognitron vor, ein Convolutional Neural Network (CNN), das den Grundstein für die Entwicklung des maschinellen Sehens legte. Alex Waibel (1987) und Jan LeCun (1989) entwickelten CNNs weiter, indem sie den Backpropagation-Algorithmus zum Trainieren der Netze verwendeten, was deren Leistung bei Erkennungsaufgaben erheblich verbesserte.

Flexibilität und Kontextuelles Lernen

Seit 1997 hat Sven Behnke den Deep-Learning-Ansatz durch die Einführung von Side- und Backpropagation in die Pyramide der neuronalen Abstraktionen erweitert. Dadurch können die Netzwerke den Kontext flexibler berücksichtigen und lokale Mehrdeutigkeiten bei der Entscheidungsfindung besser auflösen.

Terminologie und Verbreitung

Der Begriff „Deep Learning“ wurde erstmals 1986 von Rina Dechter verwendet, obwohl er damals eine etwas andere Bedeutung hatte. Das moderne Verständnis des Begriffs, der sich auf künstliche neuronale Netze bezieht, nahm im Jahr 2000 Gestalt an und wurde durch die Arbeiten von Igor Eisenberg und seinen Kollegen weithin bekannt.

Internationale Wettbewerbe und Auszeichnungen

Von 2009 bis 2012 haben tiefe neuronale Netze aus der Forschungsgruppe von Jürgen Schmidhuber am IDSIA-Labor in der Schweiz herausragende Ergebnisse erzielt und internationale Wettbewerbe im Bereich der Mustererkennung und des maschinellen Lernens gewonnen. Ein wichtiger Erfolg war die Anwendung von LSTM-Netzen zur Erkennung von zusammenhängender Handschrift, was die hohe Leistungsfähigkeit von Deep Learning bestätigt.

Jüngste Erfolge und Auszeichnungen

Bedeutende Fortschritte im Bereich Deep Learning, wie der Sieg von AlphaGo über die Go-Weltmeister und Durchbrüche bei der Vorhersage der Proteinfaltung, unterstreichen die wachsende Leistungsfähigkeit und den Einfluss dieser Technologie. 2018 wurden Yann LeCun, Yoshua Bengio und Jeffrey

Hinton für ihre Beiträge zu neuronalen Netzen und Deep Learning mit dem Turing Award ausgezeichnet, der die Bedeutung ihrer Arbeit für den gesamten Bereich der Künstlichen Intelligenz würdigt.

Dieses Kapitel beleuchtet kurz die wichtigsten Momente und Persönlichkeiten in der Geschichte des Deep Learning und zeigt die Entwicklung von den ersten Konzepten bis hin zu den heutigen bahnbrechenden Technologien und der Anerkennung in der wissenschaftlichen Gemeinschaft.

3. Grundlagen der Deep Learning Architektur

Von Neuronen zu Netzen: Bausteine der Deep Learning Architektur

Einführung in die Deep Learning Architektur

Die Deep Learning Architektur bietet einen strukturellen und funktionalen Rahmen für die Entwicklung künstlicher neuronaler Netze, die selbstlernend und anpassungsfähig sind. Diese Netze ahmen die Lernmechanismen des menschlichen Gehirns nach und ermöglichen es Computern, automatisch komplexe Muster aus Daten zu extrahieren.

Mehrschichtigkeit und Tiefe

Eine Schlüsselkomponente tiefer neuronaler Netze ist ihre mehrschichtige Struktur, die aus einer Eingabeschicht, mehreren verborgenen Schichten und einer Ausgabeschicht besteht. Die Anzahl und Komplexität dieser verborgenen Schichten bestimmt die „Tiefe“ des Netzes, d.h. die Fähigkeit, Daten auf einer tieferen Ebene zu verarbeiten und zu analysieren.

Architektonische Elemente

- Versteckte Schichten: Deep-Learning-Kern, bei dem jede Schicht auf das Lernen bestimmter Eigenschaften der Daten spezialisiert ist.

- Neuronen: Die grundlegenden Recheneinheiten des Netzes, die biologischen Neuronen nachempfunden sind. Jedes Neuron empfängt Eingabedaten, verarbeitet sie und gibt die Ausgabe an die nächste Schicht weiter.

- Gewichte und Verzerrungen: Parameter, die neuronale Netze während des Trainings anpassen, um ihre Leistung zu optimieren.

- Aktivierungsfunktionen: Legen fest, wie ein Neuron auf ein summiertes Eingangssignal reagieren soll. Beispiele sind ReLU, Sigmoid und Tangential Hyperbolicus.

Convolutional Neural Networks (CNNs)

CNNs sind eine spezielle Art von tiefen neuronalen Netzen, die für die Verarbeitung von Daten mit gitterartiger Struktur, wie z.B. Bilder, entwickelt wurden. CNNs verwenden Faltungsschichten zur automatischen und effizienten Merkmalsextraktion, wodurch die Notwendigkeit manueller Merkmalsextraktion und Vorverarbeitung reduziert wird.

Rekurrente Neuronale Netze (RNN)

RNNs sind für die Verarbeitung von sequentiellen oder zeitlichen Daten wie Text oder Zeitreihen konzipiert. Sie können frühere Kontexte berücksichtigen, da sie in der Lage sind, Informationen von einem Schritt zum nächsten weiterzugeben und dabei ein „Gedächtnis“ für frühere Eingabedaten zu behalten.

Deep Reinforcement Learning

Deep Reinforcement Learning kombiniert Techniken des Deep Learning und des Reinforcement Learning und ermöglicht es Modellen, sich dynamisch an veränderte Kontexte anzupassen und ihre Strategien zu optimieren, um bestimmte Ziele zu erreichen. Dies ist besonders nützlich für Aufgaben, die konsistente Entscheidungen und Anpassungen erfordern, wie z.B. Spiele oder Robotik.

Architektonische Innovationen

Fortschritte im Deep Learning gehen einher mit der Entwicklung neuer Architekturen wie Transformatoren, die aufgrund ihrer Fähigkeit, lange Abhängigkeiten in Daten effizient zu verarbeiten, bisherige Modelle zur Verarbeitung natürlicher Sprache übertreffen.

Deep-Learning-Architekturen entwickeln sich ständig weiter und bieten immer leistungsfähigere und effizientere Modelle für die Datenanalyse. Das Verständnis dieser Grundlagen ermöglicht eine bessere Einschätzung der Möglichkeiten und Grenzen von Deep Learning sowie seiner potenziellen Entwicklungsrichtungen.

4. Wie funktioniert Deep Learning?

Vom Eingang bis zur Entscheidung: Entschlüsselung des Deep Learning Prozesses

Deep Learning ist ein Prozess, bei dem künstliche neuronale Netze große Datenmengen analysieren und daraus lernen. Dieser Prozess umfasst mehrere wichtige Schritte, von der Eingabeschicht, in der Daten in das Modell eingegeben werden, bis zur Ausgabeschicht, in der die endgültige Schlussfolgerung oder Entscheidung getroffen wird.

Forward Propagation

- Eingabedaten: Alles beginnt mit der Eingabe von Eingabedaten in das Modell, wobei jedes Datenattribut mit einem Neuron in der Eingabeschicht verbunden wird.

- Gewichte und Offsets: Die Daten werden mit Gewichten multipliziert und dem Ergebnis wird ein Offset hinzugefügt, um das Modell besser an die Daten anzupassen.

- Aktivierung: Anwendung einer Aktivierungsfunktion, z. B. ReLU oder Sigmoid, auf das Ergebnis von Gewichtung und Bias, um Nichtlinearität einzuführen, damit das Netz komplexere Muster lernen kann.

Backpropagation

- Bewertung des Fehlers: Berechnung der Differenz zwischen der Modellvorhersage und dem tatsächlichen Wert unter Verwendung einer Verlustfunktion wie dem RMS-Fehler.

- Optimierung: Verwendung von Optimierungsalgorithmen, wie z. B. Gradientenabstieg, zur Anpassung von Gewichten und Verzerrungen in umgekehrter Richtung, d. h. von der Ausgabeschicht zur Eingabeschicht, um den Fehler zu minimieren.

- Parameter-Aktualisierung: Gewichte und Offsets werden mit der Ableitung der Verlustfunktion aktualisiert, um die Modellleistung zu verbessern.

Iterationen und Epochen

- Epochen: Das Modelltraining erfolgt in der Regel über mehrere Epochen, wobei jede Epoche einen einzelnen Durchlauf des gesamten Trainingsdatensatzes darstellt.

- Mini-Batch: Die Daten werden häufig in kleine Gruppen, so genannte Minibatches, aufgeteilt, um den Trainingsprozess effizienter zu gestalten und lokale Minima der Verlustfunktion zu vermeiden.

Automatische Merkmalsextraktion

Deep Learning extrahiert und kombiniert automatisch Merkmale auf verschiedenen Abstraktionsebenen, so dass das Modell auf komplexen Daten ohne Vorverarbeitung oder manuelle Merkmalsextraktion trainiert werden kann.

Regularisierung und Vermeidung von Übertraining

- Dropout: Eine Technik, bei der in jedem Trainingsschritt eine zufällige Gruppe von Neuronen vorübergehend entfernt wird, um Übertraining zu vermeiden.

- Früher Abbruch: Der Prozess des Beendens des Trainings, wenn der Fehler in einem Validierungsdatensatz zu steigen beginnt, was den Beginn des Übertrainings anzeigt.

Deep Learning ist ein leistungsfähiger Prozess, der komplexe Berechnungen und Algorithmen beinhaltet, um Modelle aus Daten zu trainieren. Dieser Prozess umfasst Vorwärts- und Rückwärtspropagation, automatische Merkmalsextraktion, Regularisierung und andere Techniken, um robuste und effiziente Modelle der künstlichen Intelligenz zu erstellen.

5. Deep Learning und Machine Learning: Was ist der Unterschied?

Unterschiede und Synergien: ML vs. DL

Machine Learning und Deep Learning im Überblick

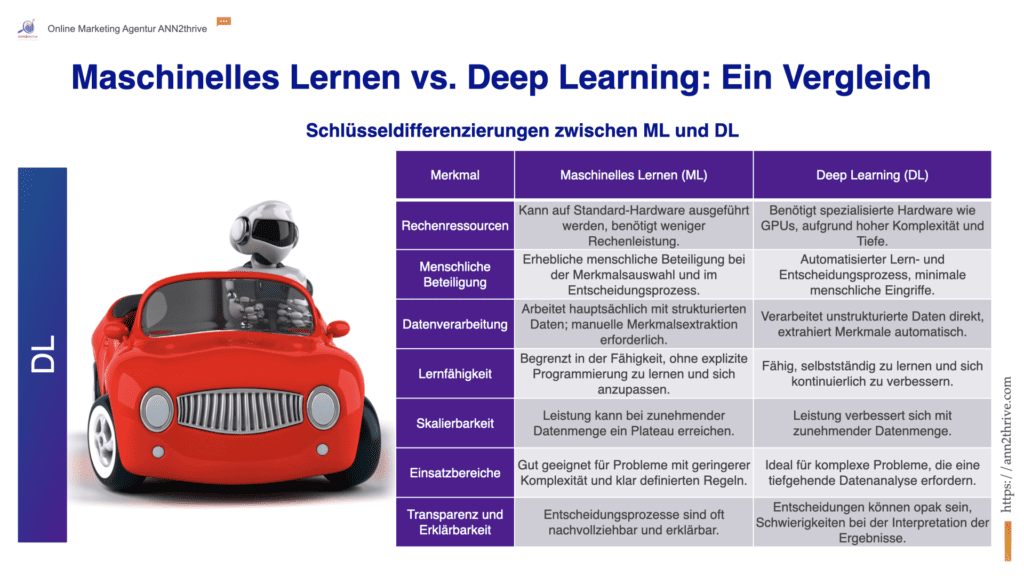

Maschinelles Lernen (ML) und Deep Learning (DL) sind wichtige Teilbereiche der Künstlichen Intelligenz (KI), unterscheiden sich jedoch erheblich in ihren Ansätzen und Fähigkeiten. Deep Learning, eine Untergruppe des maschinellen Lernens, verwendet hochentwickelte neuronale Netzwerke, um Daten zu verarbeiten und Entscheidungen zu treffen.

Anforderungen an Rechenressourcen

- Maschinelles Lernen: Herkömmliche ML-Algorithmen können effizient auf Standard-Hardware ausgeführt werden und benötigen oft nur einen oder wenige Prozessoren, um Modelle zu trainieren.

- Deep Learning: DL-Modelle benötigen aufgrund ihrer Komplexität und Tiefe oft spezielle Rechenhardware wie GPUs, TPUs oder FPGAs, was den Trainingsprozess wesentlich ressourcenintensiver und teurer macht.

Menschliche Beteiligung am Lernprozess

- Maschinelles Lernen: Beim ML spielt der Mensch eine aktive Rolle, indem er die zu analysierenden Merkmale auswählt und am Entscheidungsprozess teilnimmt.

- Deep Learning: Beim DL stellt der Mensch die Daten zur Verfügung und legt die allgemeinen Lernziele fest, aber der Lernprozess selbst, die Datenanalyse und die Entscheidungsfindung sind vollständig automatisiert. Das bedeutet, dass es nach dem Training schwierig ist, nachzuvollziehen, wie die Maschine zu einer bestimmten Schlussfolgerung gekommen ist.

Datenverarbeitung

- Maschinelles Lernen: ML-Algorithmen arbeiten häufig mit strukturierten, markierten Daten, die eine Vorverarbeitung und manuelle Merkmalsextraktion erfordern.

- Deep Learning: DL ist in der Lage, unstrukturierte Daten direkt zu verarbeiten, die benötigten Merkmale automatisch zu extrahieren und die Abhängigkeit von menschlichen Eingriffen zu verringern.

Selbstlernend und anpassungsfähig

Tiefe neuronale Netze sind in der Lage, selbst zu lernen, sich ständig zu verbessern und sich an neue Daten anzupassen. Dadurch können sie komplexere Aufgaben bewältigen und ihre Leistung steigern, wenn die Menge der verarbeiteten Informationen zunimmt.

Skalierbarkeit und Performanz

Im Gegensatz zu klassischen ML-Methoden verbessert sich die Leistung von DL-Algorithmen mit der Menge der verfügbaren Trainingsdaten, wodurch sie sich besonders für die Verarbeitung großer Datensätze eignen.

Obwohl Deep Learning ein Teil des maschinellen Lernens ist, zeichnet es sich durch eine tiefere Ebene der Datenanalyse und -verarbeitung durch den Einsatz hochentwickelter neuronaler Netze aus. Dies ermöglicht es DL-Modellen, automatisch Merkmale zu extrahieren und sich an neue Aufgaben anzupassen, erfordert aber auch wesentlich mehr Rechenressourcen und Daten für das Training.

6. Warum ist Deep Learning wichtig?

Enthüllung der Potenziale und Herausforderungen von Deep Learning

Beeindruckende Komplexität und Leistungsfähigkeit

Tiefe neuronale Netze haben eine enorme Komplexität mit Millionen von Parametern und Milliarden von Rechenoperationen, um jede Einheit von Eingabedaten zu verarbeiten. Diese Leistungsfähigkeit ermöglicht es ihnen, komplexe Muster und Beziehungen in den Daten zu lernen und zu modellieren, die für frühere Methoden des maschinellen Lernens unerreichbar waren.

Herausforderungen der Interpretierbarkeit

Eine der Herausforderungen beim Deep Learning ist die Schwierigkeit, die internen Prozesse und Entscheidungen zu interpretieren. Es gibt spezifische Ansätze und Techniken, die darauf abzielen, die Prozesse in neuronalen Netzen besser zu erklären und zu verstehen, aber diese befinden sich noch in der Entwicklung und sind nicht immer einfach anzuwenden.

Anfälligkeit für Angriffe

Deep Learning ist auch anfällig für das Gegenteil – subtile und oft vom Menschen unbemerkte Manipulationen der Eingabedaten, die zu falschen Schlussfolgerungen führen können. Dieses Phänomen erfordert weitere Forschung und die Entwicklung von Abwehrmechanismen.

KI-Ethik und Transparenz

Fragen der Transparenz und Kontrolle von Künstlicher Intelligenz werden insbesondere im Zusammenhang mit Deep Learning relevant. Es wird unterschieden zwischen „intransparenter KI“, zu der auch tiefe neuronale Netze gehören, und „transparenter KI“, deren Entscheidungen von Menschen leicht verstanden und interpretiert werden können. Die Balance zwischen diesen Ansätzen bestimmt den ethisch-moralischen Rahmen für den Einsatz von KI.

Vorteile in der Datenverarbeitung

Deep Learning ist besonders effektiv bei der Verarbeitung unstrukturierter Daten wie Bilder, Texte und Audio. Diese Algorithmen können automatisch aussagekräftige Merkmale aus solchen Daten extrahieren, was sie ideal für den Aufbau fortschrittlicher Empfehlungssysteme, Spracherkennung und Bildverarbeitung macht.

Auswirkungen auf Technologie und Alltag

Deep Learning hat bereits zu bedeutenden Durchbrüchen in vielen Bereichen geführt, vom autonomen Fahren über die Spracherkennung bis hin zur medizinischen Bildanalyse. Diese Fortschritte versprechen, viele Aspekte unseres täglichen Lebens radikal zu verändern und die Technologie intuitiver und zugänglicher zu machen.

Bedarf an großen Datenmengen und Rechenressourcen

Tiefe neuronale Netze benötigen große Datensätze und erhebliche Rechenleistung, insbesondere von Grafikprozessoren (GPUs), um effizient trainiert werden zu können. Diese Anforderung ist sowohl ein Hindernis als auch ein Katalysator für KI-Innovationen.

Deep Learning ist ein leistungsfähiges Werkzeug zur Erforschung und Modellierung komplexer Daten und eröffnet neue Möglichkeiten für die Technologieentwicklung und für Anwendungen in verschiedenen Lebensbereichen. Gleichzeitig stellt es Forscher und Entwickler vor neue Herausforderungen in Bezug auf die Interpretierbarkeit, Ethik und Sicherheit von KI.

7. Anwendungen von Deep Learning

Von Siri bis zur medizinischen Diagnostik: Deep Learning revolutioniert Branchen

Analyse von großen Datenmengen

Deep Learning eignet sich ideal für die Analyse großer Datenmengen und ermöglicht die Erkennung komplexer Muster und Modelle. Dies ist insbesondere in der Sprach-, Gesichts- und Objekterkennung von Bedeutung, wo Deep Learning basierte Systeme ihre Fähigkeiten selbstständig erweitern können.

Sprach- und Bilderkennung

Der Einsatz von Deep Learning in der Spracherkennung, z.B. bei Apples Siri, ermöglicht es Systemen, menschliche Sprache mit hoher Genauigkeit zu verstehen und zu interpretieren. Auch in der Bildverarbeitung spielt Deep Learning eine wichtige Rolle, etwa bei der Gesichtserkennung von Facebook oder der Bildersuche von Google.

Industrie und Produktion

In Fertigungsunternehmen hilft Deep Learning bei der Auswertung von Sensordaten, um Prozesse zu optimieren und Wartungszeitpunkte von Anlagen vorherzusagen, um Ausfälle zu vermeiden.

Autonomes Fahren

In der Automobilindustrie wird Deep Learning eingesetzt, um autonome Fahrsysteme zu entwickeln, mit denen Autos ihre Umgebung wahrnehmen und in Echtzeit Entscheidungen treffen können.

Medizinische Diagnose

In der Medizin wird Deep Learning zur Analyse medizinischer Bilder eingesetzt, beispielsweise zur Erkennung von Krebszellen, wodurch die Genauigkeit und Geschwindigkeit von Diagnosen erheblich verbessert wird.

Finanzsektor

Im Finanzsektor hilft Deep Learning bei der Betrugserkennung und der Verwaltung von Investmentportfolios durch die Analyse großer Mengen von Transaktionsdaten.

Kundenservice

Deep-Learning-Technologien werden in Kundenservices wie Chatbots und virtuelle Assistenten integriert, um deren Fähigkeit zu verbessern, Nutzeranfragen zu verstehen und zu beantworten.

Anwendungsbeispiele

- Google Translate hat die Übersetzungsqualität durch den Einsatz künstlicher neuronaler Netze erheblich verbessert.

- Computer Vision hat seit der Entwicklung von LeNet-5 im Jahr 1998 erhebliche Fortschritte bei der Bildklassifikation gemacht.

- Chatbots und virtuelle Assistenten werden immer intelligenter und sind dank Deep Learning in der Lage, komplexe Anfragen zu beantworten.

- Die medizinische Diagnostik profitiert von der Anwendung von Deep Learning in der Bildanalyse, um Krankheiten genauer und schneller zu erkennen.

- In der Automobiltechnik wird Deep Learning bei der Entwicklung von autonomen Fahrsystemen eingesetzt, um die Sicherheit und Effizienz im Straßenverkehr zu erhöhen.

Deep Learning kommt in vielen Bereichen zum Einsatz, von der Automobiltechnik über die medizinische Diagnostik bis hin zum Kundendienst, verändert die Art und Weise, wie wir mit Daten arbeiten, und eröffnet neue Horizonte für Forschung und Entwicklung in allen Branchen.

8. Wie erstelle und trainiere ich Deep Learning Modelle?

Grundlagen und Strategien für effektives Deep Learning Training

Methoden zur Modellbildung

Lernen von Grund auf

- Von Grund auf: Die Erstellung eines Modells von Grund auf erfordert eine große Menge an klassifizierten Daten und die Entwicklung einer spezifischen Netzwerkarchitektur.

- Anwendung: Geeignet für innovative Anwendungen mit mehreren Ausgabekategorien.

- Herausforderungen: Je nach Datenmenge und Trainingsgeschwindigkeit kann der Trainingsprozess Tage bis Wochen dauern.

Transfer Lernen

- Grundprinzip: Verwendung eines zuvor trainierten Modells für neue Aufgaben durch Anpassung des Netzes an neue Datenklassen.

- Vorteile: Benötigt weniger Daten und Zeit (Minuten bis Stunden), wodurch der Prozess zugänglicher und effizienter wird.

- Werkzeuge: MATLAB® bietet Werkzeuge, die das Transferlernen vereinfachen.

Merkmalsextraktion

- Merkmal: Verwendung des Netzes als Merkmalsextraktor, wobei in jeder Trainingsphase Merkmale extrahiert werden, um sie später in anderen maschinellen Lernmodellen zu verwenden.

- Anwendung: Kann verwendet werden, um Merkmale in maschinelle Lernmodelle wie die Support Vector Machine (SVM) einzuspeisen.

GPU-beschleunigtes Lernen

- Die GPU-Beschleunigung reduziert die Trainingszeit drastisch, so dass eine Bildklassifikationsaufgabe von Tagen auf Stunden verkürzt werden kann.

- MATLAB® nutzt automatisch die verfügbaren GPUs, um den Trainingsprozess zu beschleunigen.

Deep-Learning-Frameworks

- TensorFlow: Eines der populärsten von Google entwickelten Frameworks, das die Erstellung und das Training von Modellen in einer Vielzahl von Programmiersprachen unterstützt.

- Keras: Eine High-Level-API, ideal für die schnelle Implementierung von neuronalen Netzen, die mit TensorFlow und anderen Frameworks verwendet werden kann.

- PyTorch: Bietet dynamische neuronale Netze und wird von der Facebook AI Research Group unterstützt.

- MXNet, Gluon, Chainer, Deeplearning4j: Weitere wichtige Frameworks, jedes mit eigenen Funktionen und bevorzugten Anwendungsgebieten.

Empfehlungen zur Auswahl eines Frameworks

- Die Wahl des Frameworks hängt von den spezifischen Anforderungen des Projekts, den verfügbaren Daten, der benötigten Rechenleistung und der bevorzugten Programmiersprache ab.

- TensorFlow und Keras bieten Flexibilität und umfangreiche Möglichkeiten zur Modellanpassung, während PyTorch einen intuitiveren Zugang zur dynamischen Netzwerkmodellierung bietet.

Software-Bibliotheken und Werkzeuge

- Es gibt zahlreiche Open-Source-Softwarebibliotheken, die verschiedene Programmiersprachen und Plattformen unterstützen und zur Beschleunigung der Entwicklung und des Trainings von Deep-Learning-Modellen eingesetzt werden können.

- ONNX bietet eine komfortable Möglichkeit, Modelle zwischen verschiedenen Frameworks auszutauschen, was die Integration und Portabilität erleichtert.

Das Erstellen und Trainieren von Deep-Learning-Modellen umfasst die Auswahl einer geeigneten Trainingsmethode, den Einsatz von Grafikprozessoren zur Beschleunigung des Prozesses, die Auswahl und Anwendung eines geeigneten Frameworks und die Integration mit Softwarebibliotheken und Tools zur Optimierung des Entwicklungsprozesses.

9. Schlusswort von ANN2thrive

Von ANN2thrive für Sie: Eintauchen in die Welt des Deep Learning

Bei unserer Online-Marketing-Agentur ANN2thrive staunen wir, wie Deep Learning in Bereichen wie Spracherkennung, Bildverarbeitung und personalisierten Empfehlungen bereits einen Wendepunkt erreicht hat. Die Technologie wird jeden Tag intelligenter und eröffnet ungeahnte Möglichkeiten. Unsere Forschung und Entwicklung in diesem Bereich automatisiert die komplexesten Prozesse und liefert Werte, von denen wir nur träumen konnten.

Wir sehen, wie Deep Learning Branchen verändert und das möglich macht, was früher unmöglich schien. Von der Medizin, wo die Technologie hilft, Leben zu retten, indem sie Krankheiten im Frühstadium erkennt, bis hin zur Landwirtschaft, wo sie Erträge und Effizienz steigert. Und das ist erst der Anfang.

Wir helfen Ihnen, diese Innovationen für Ihr Unternehmen nutzbar zu machen. Wenn Sie herausfinden möchten, wie Deep Learning Ihre Branche verändern kann, kontaktieren Sie uns. Gemeinsam können wir neue Wege beschreiten und eine Zukunft gestalten, in der wir alle von der Technologie profitieren. Wir haben eine aufregende Reise vor uns und freuen uns darauf, sie gemeinsam mit Ihnen zu beginnen.

10. FAQ: Tiefgehende Antworten zum Deep Learning

Häufig gestellte Fragen entschlüsselt – Ihr Leitfaden zum Verständnis von Deep Learning

Deep Learning ist ein Teilgebiet der Künstlichen Intelligenz, das Algorithmen, die der Struktur des menschlichen Gehirns ähneln, sogenannte künstliche neuronale Netze, verwendet, um Daten zu verarbeiten, zu lernen und Entscheidungen zu treffen.

Maschinelles Lernen ist eine breitere Kategorie der künstlichen Intelligenz, die auch Deep Learning umfasst. Der Hauptunterschied liegt in der Struktur und Komplexität der Modelle: Deep Learning verwendet tiefe neuronale Netze mit vielen Schichten, während maschinelles Lernen einfachere Algorithmen verwenden kann.

Deep Learning wird in vielen Bereichen eingesetzt, z.B. Sprach- und Bilderkennung, autonomes Fahren, medizinische Diagnostik, Empfehlungssysteme und vieles mehr.

Für das Training von Deep-Learning-Modellen werden häufig spezielle Rechenressourcen wie Grafikprozessoren (GPUs) oder Tensor Processing Units (TPUs) benötigt, die große Datenmengen verarbeiten und komplexe Berechnungen schneller durchführen können als Standard-CPUs.

Die Zeit, die benötigt wird, um ein Deep-Learning-Modell zu trainieren, kann zwischen einigen Stunden und einigen Wochen liegen und hängt von der Komplexität des Modells, der Menge und Art der Daten und den Rechenressourcen ab.

Neuronale Netze sind Deep-Learning-Frameworks, die aus in Schichten verbundenen Knoten (Neuronen) bestehen. Sie ahmen die Struktur und Funktionsweise des menschlichen Gehirns nach, um Daten zu verarbeiten und zu lernen.

Beim Lernen mit Lehrer werden vorgelernte Daten verwendet, wobei das Modell an Beispielen mit bekannten Antworten trainiert wird. Beim Lernen ohne Lehrer werden unmarkierte Daten verwendet, so dass das Modell selbstständig verborgene Strukturen und Muster finden kann.

Ja, Deep-Learning-Modelle können Fehler machen, insbesondere wenn die Trainingsdaten begrenzt, nicht ausreichend vielfältig oder verzerrt sind.

Sicherheit und Datenschutz beim Deep Learning werden durch Datenverschlüsselung, Anonymisierung, Datenschutz und die Verwendung von Sicherheitsprotokollen bei der Datenübertragung gewährleistet.

Deep Learning entwickelt sich ständig weiter und bringt Innovationen in Bereichen, die vom Gesundheitswesen bis zur Automobilindustrie reichen. Zukünftige Forschung wird sich voraussichtlich darauf konzentrieren, die Effizienz zu steigern, den Bedarf an Rechenressourcen zu reduzieren und besser interpretierbare Modelle zu entwickeln.

Marketing Analytics mit KI -

Treiben Sie Ihren Erfolg durch Daten voran

Entfesseln Sie das volle Potenzial Ihrer Marketingdaten mit der Kraft der Künstlichen Intelligenz! Wir bieten Ihnen fortschrittliche Tools und Expertise, um tiefgreifende Einblicke zu gewinnen und fundierte Entscheidungen zu treffen. Unsere KI-gestützten Analysemethoden helfen Ihnen, verborgene Chancen zu identifizieren und Ihre Marketingstrategien gezielt zu optimieren. Mit uns als Ihrem Partner nutzen Sie Daten nicht nur, um Trends zu verstehen, sondern auch, um Ihr Unternehmen aktiv voranzutreiben. Starten Sie jetzt in eine datengetriebene Zukunft, in der jede Entscheidung Ihr Wachstum fördert.